[SSDA][Seg] DDM: Semi-supervised Domain Adaptation based on Dual-level Domain Mixing for Semantic Segmentation

[SSDA][Seg] DDM: Semi-supervised Domain Adaptation based on Dual-level Domain Mixing for Semantic Segmentation

- paper: https://openaccess.thecvf.com/content/CVPR2021/papers/Chen_Semi-Supervised_Domain_Adaptation_Based_on_Dual-Level_Domain_Mixing_for_Semantic_CVPR_2021_paper.pdf

- github: x

- CVPR 2021 accpeted (인용수: 55회, ‘23.12.14 기준)

- downstream task: SSDA for Seg

1. Motivation

-

기존에 UDA, SSL은 supervised learning에 비해 large performance gap이 존재했음. 이를 줄이고자 실용적인 setting의 SSDA에 focus하고자 함

2. Contribution

- Domain Gap을 줄이는 Dual-level Domain Mixing 방식이 제안됨

- Region-level mixing으로 학습하는 teacher model

- Sample-level mixing으로 학습하는 teacher model

- Two teacher에 대해 KD 로 student를 학습함

3. Dual-level Domain Mixing

-

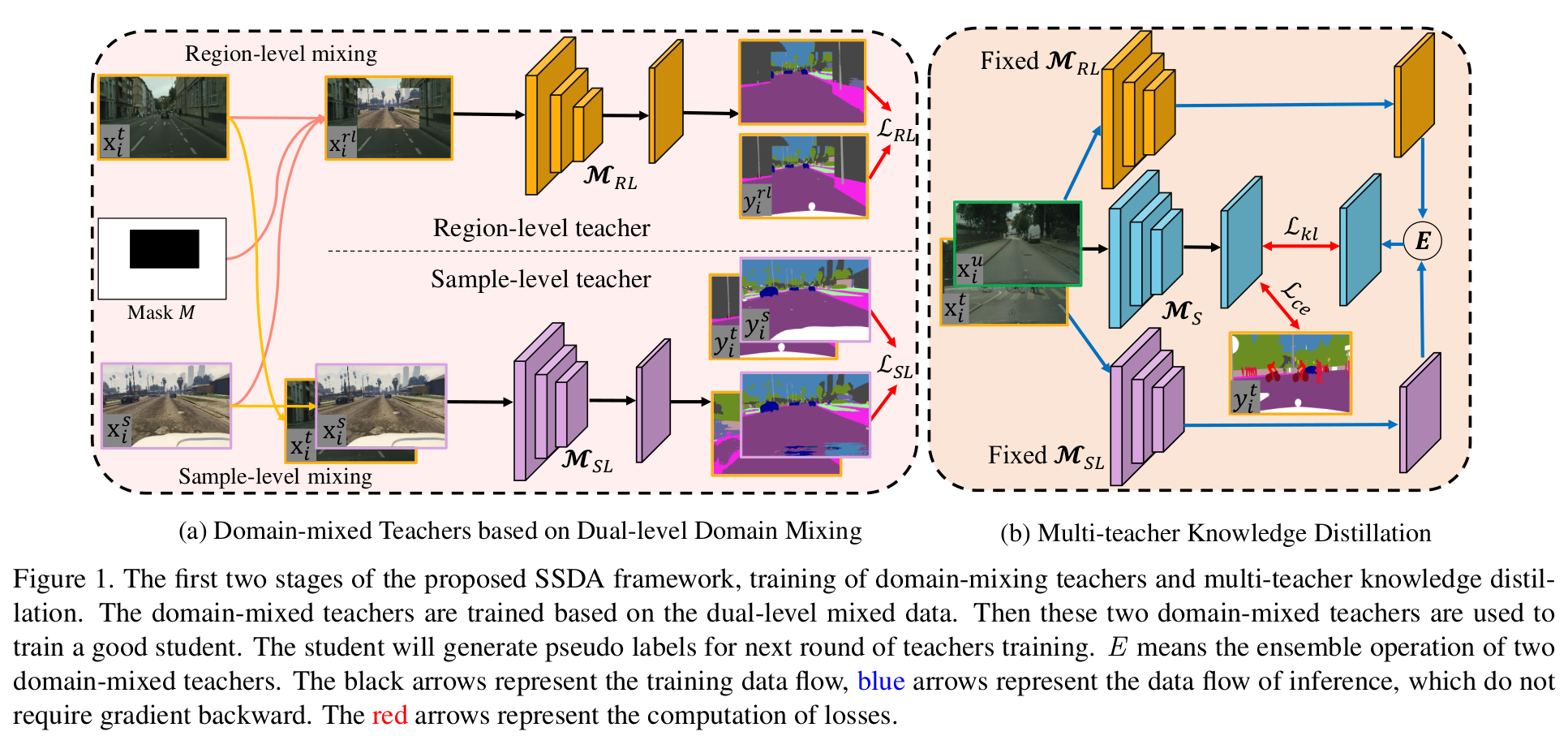

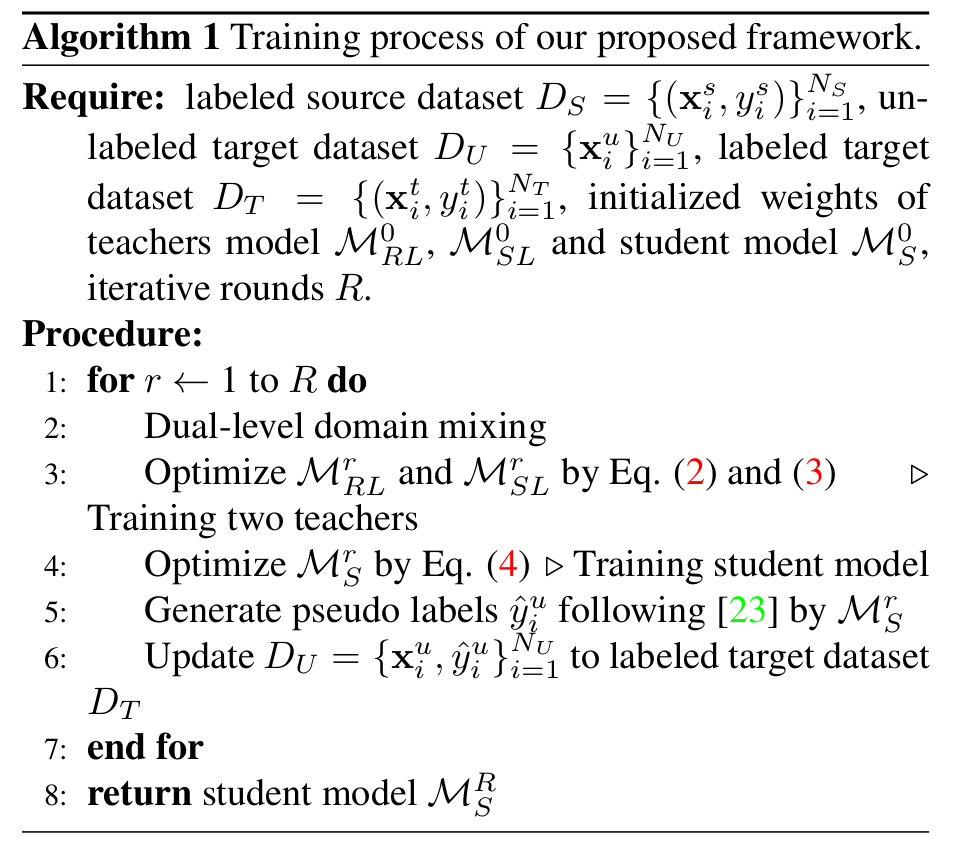

Overall diagram

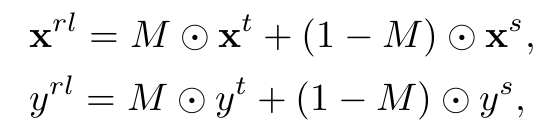

3.1 Region-level Mixing

-

CutMix에서 영감을 얻어, source labeled data와 target labeled data간의 domain gap을 줄이고자 두 개를 cutmix로 augmentation하여 학습에 활용

-

Region-level teacher를 학습하는데 활용함

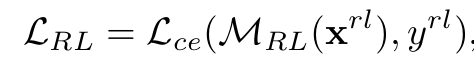

- $M_{RL}$: Region-Level teacher model

3.2 Sample-level Mixing

-

target label data는 소량이기에 overfitting 위험이 있음.

-

다량의 source label data와 1:1 비율로 학습하면 이를 완화할 수 있음

-

Sample-level teacher를 학습

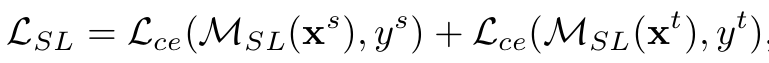

3.3 Multi-teacher Knowledge Distillation

-

Region-level teacher와 Sample-level teacher의 ensemble값을 KL Divergence로 student를 학습시킴

-

이때 ensemble은 average operation을 활용함

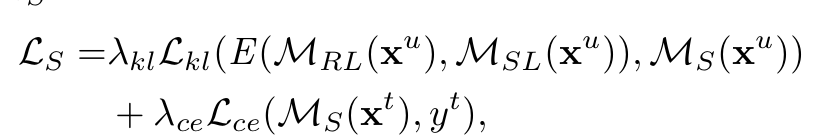

3.4 Progressive Improving Scheme

-

대량의 Target unlabeled data에 대해 progressive하게 student가 예측한 pseudo label로 target unlabel data를 target label data에 업데이트시킴

-

Overall Algorithm of DDM

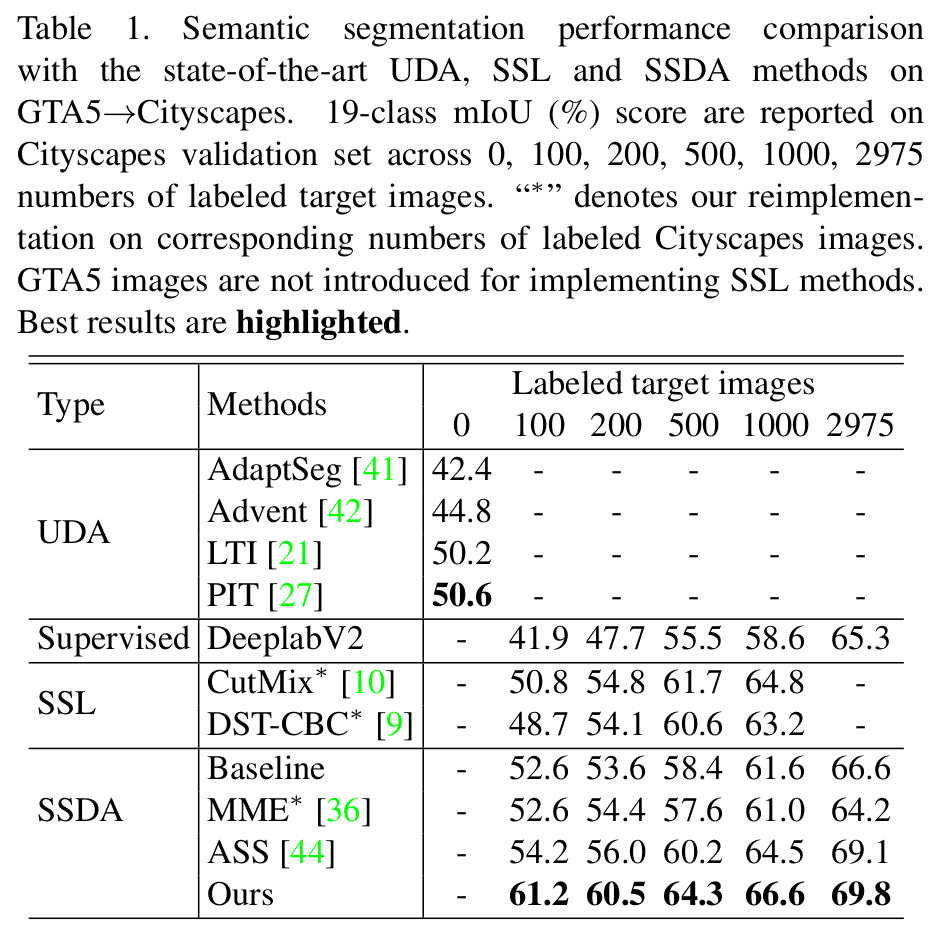

4. Experiment

-

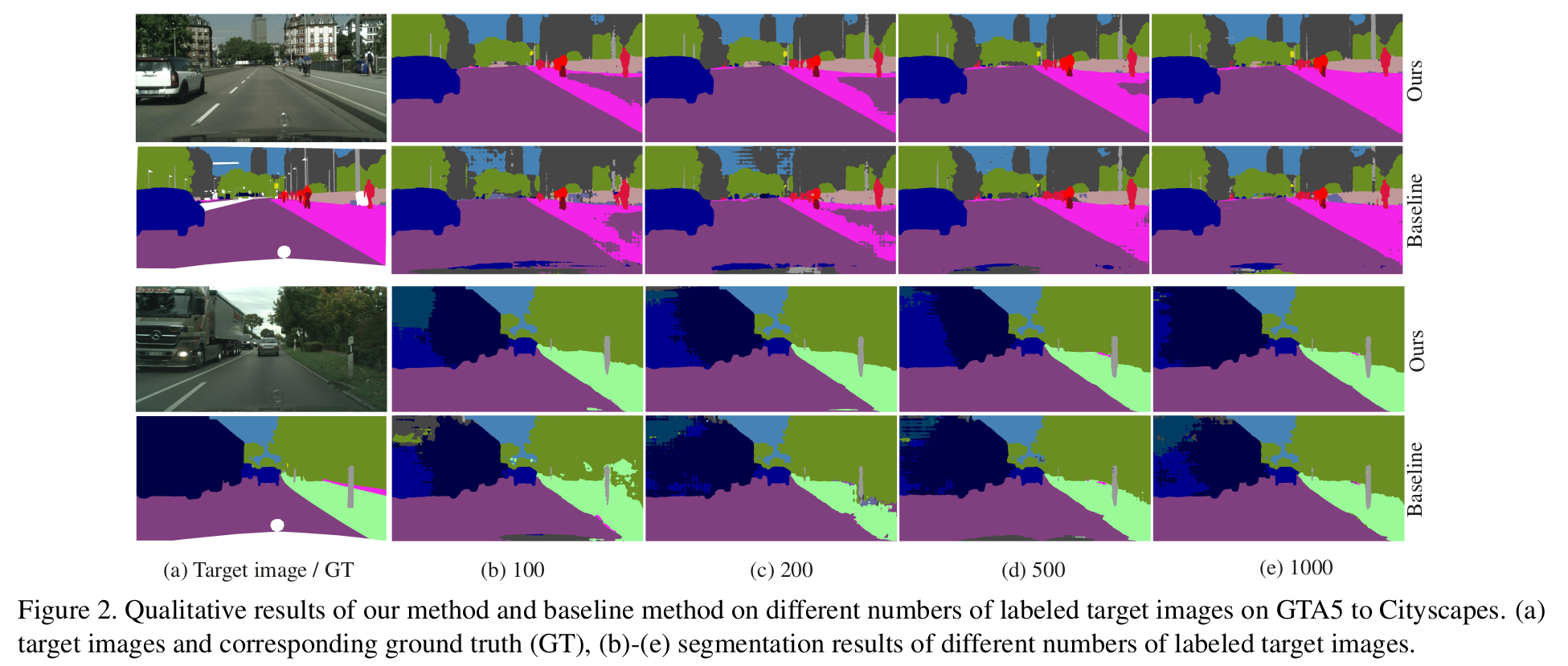

GTA2Cityscapes

-

Synthetic to real

-

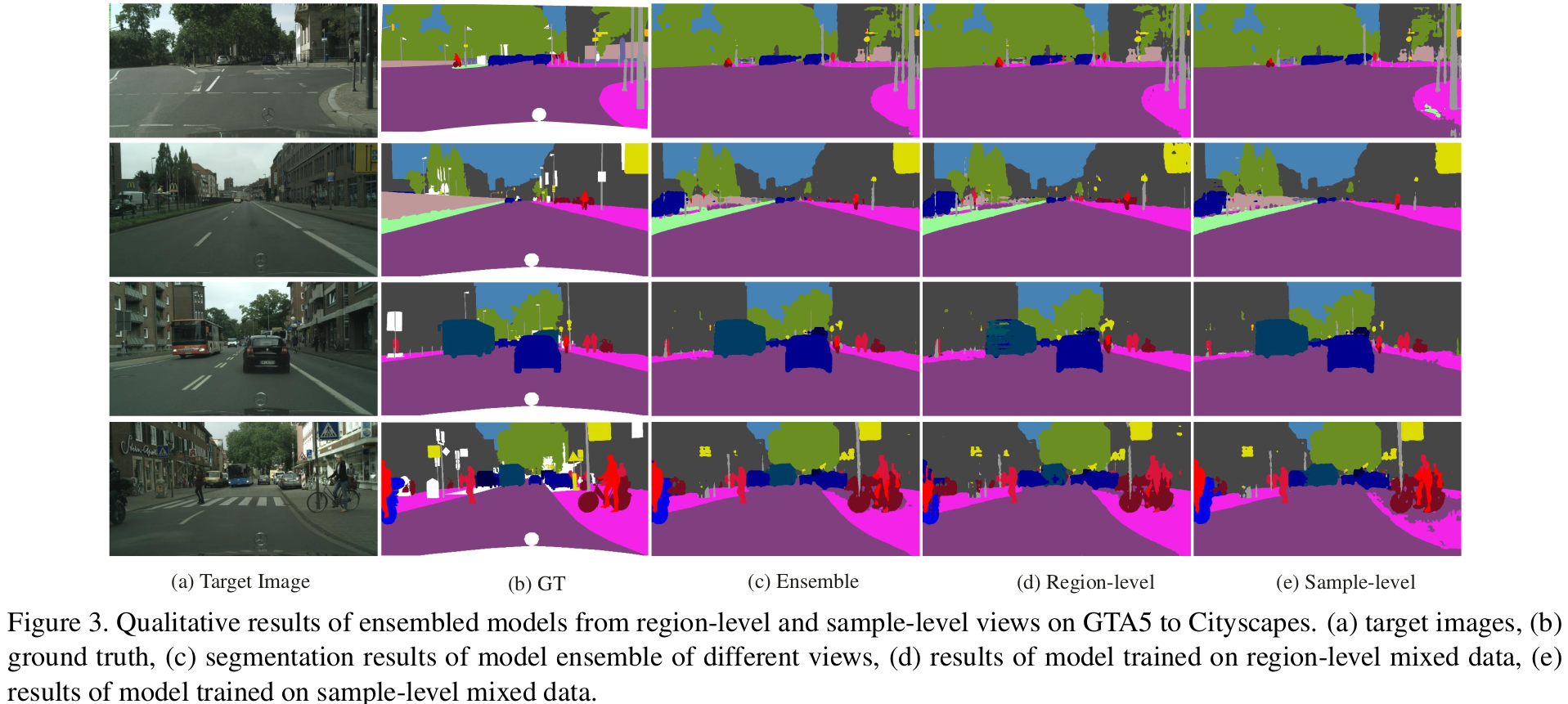

Qualitative result

-

-

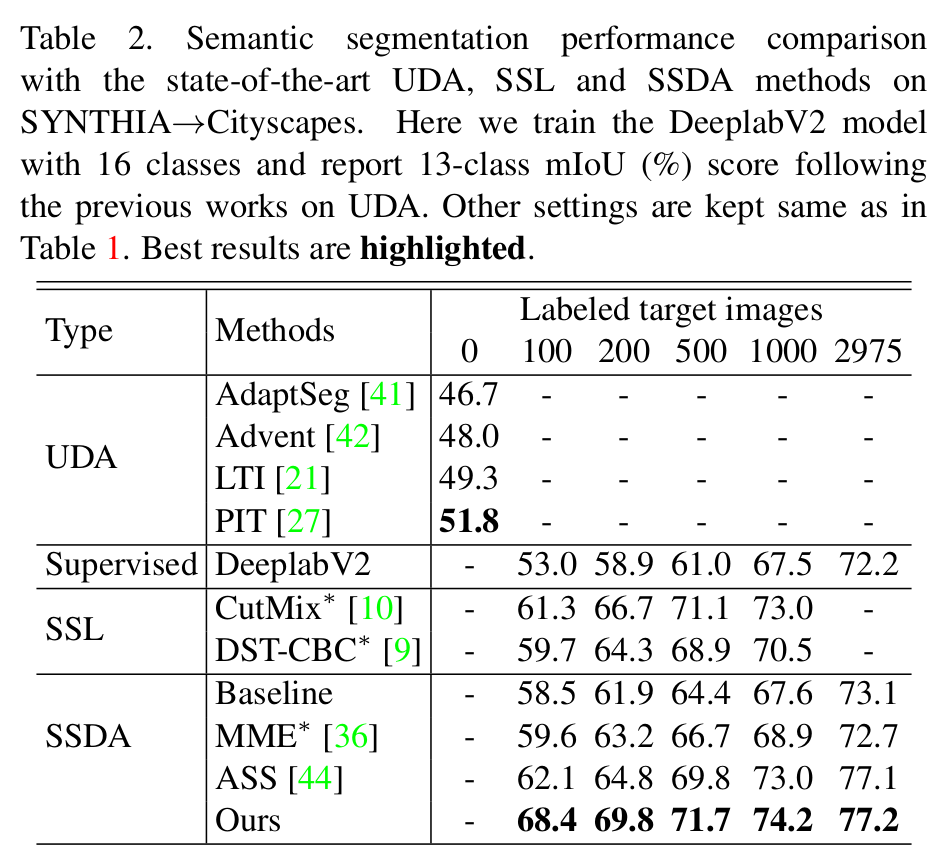

Synthia2Cityscapes

-

Synthetic to real

-

-

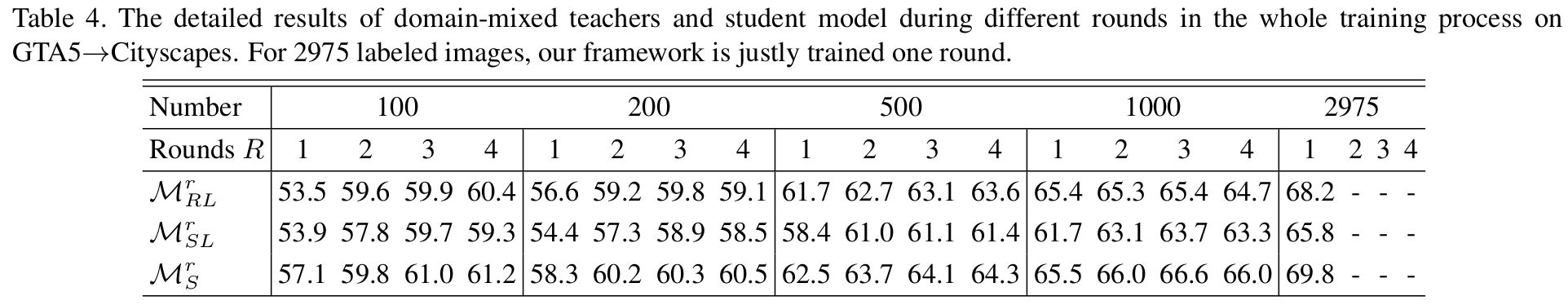

GTA2Cityscapes

-

Quantitative Result

-

Qualitative Result

-

-

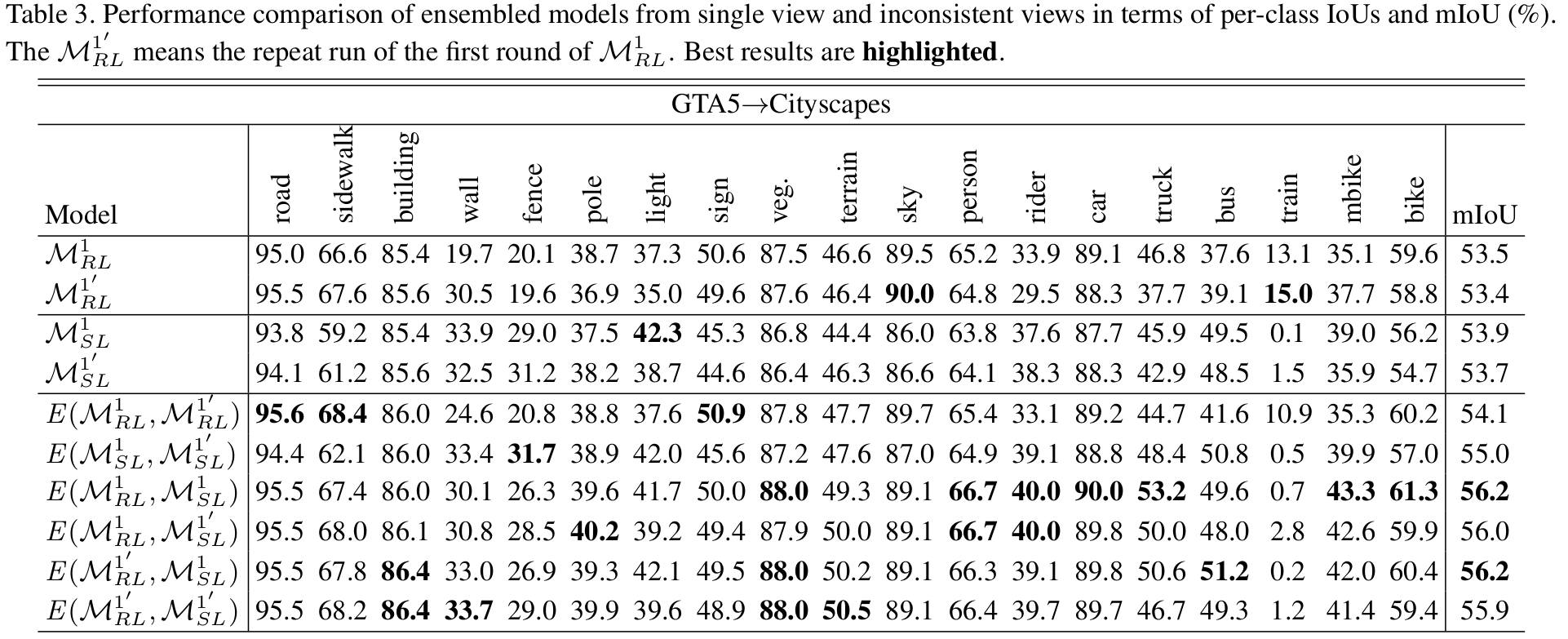

Ablation

-

dual teacher에 따른 성능

-

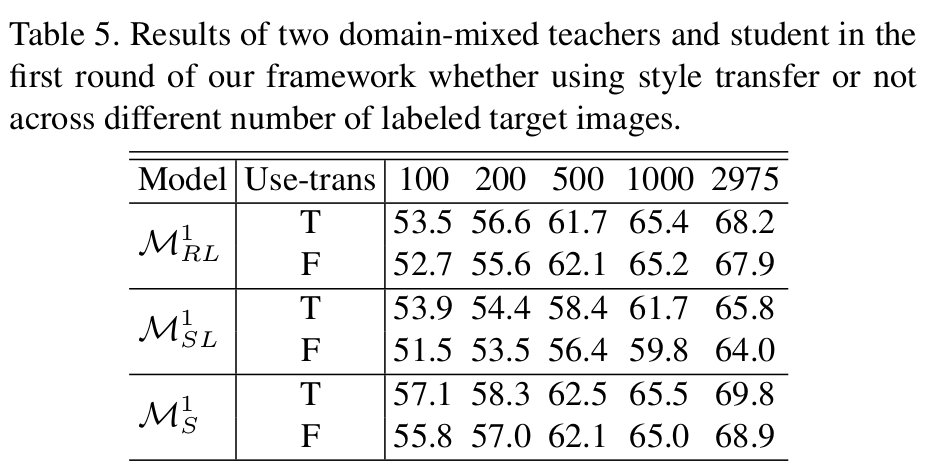

Style-Transfer 적용 유무에 따른 성능 비교

-