[TTA][CLS][SS] Continual Test-Time Domain Adaptation

[TTA][CLS][SS] Continual Test-Time Domain Adaptation

-

paper : https://arxiv.org/pdf/2203.13591.pdf

-

git : https://qin.ee/cotta/

-

CVPR 2022 (인용수 : 101회, ‘22.03)

-

downstream task : Continual Domain Adaptation for Classification & Semantic Segmentation

-

Contribution

-

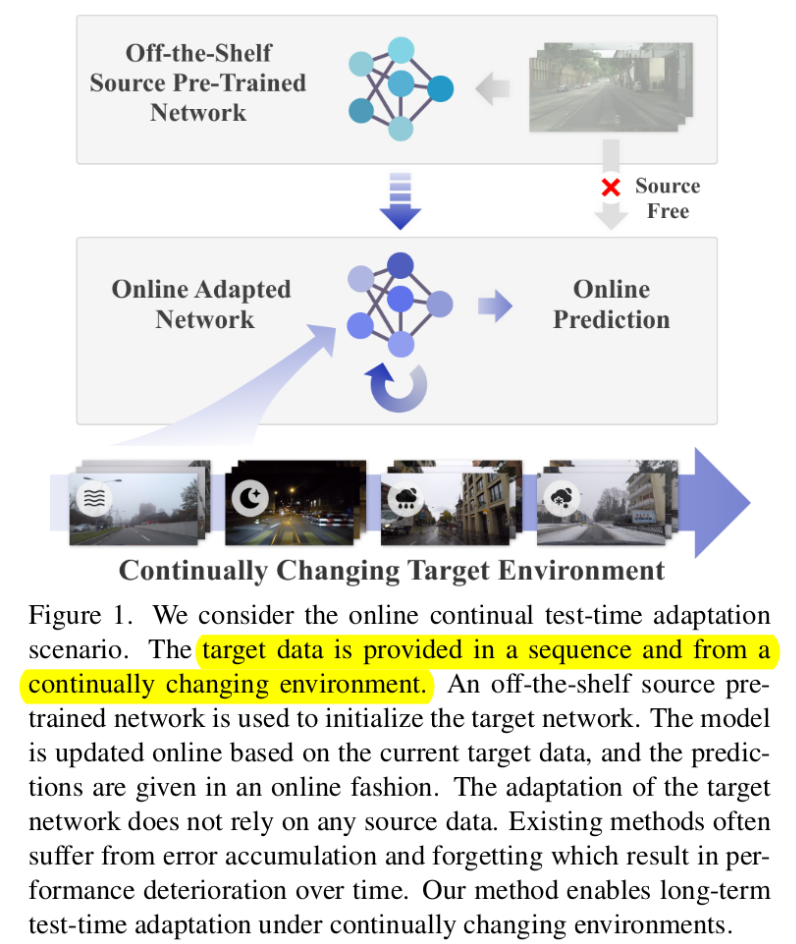

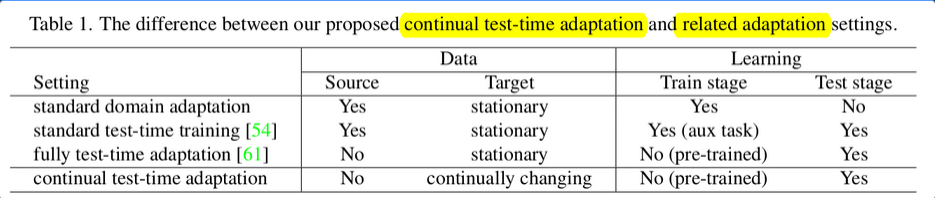

Target domain이 continually changing environment라 가정하는 “continual domain adaptation”을 제안함

-

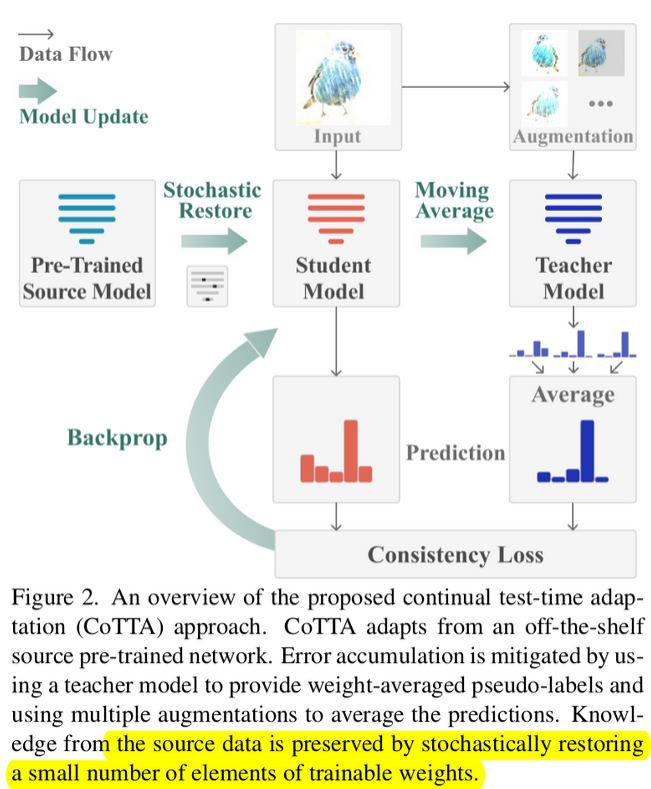

weighted-averaging (EMA) & augmentation-averaged prediction (ensemble) 사용하여 pseudo label의 quality를 향상시킴

-

stochastically network weight의 일부를 fixed-source의 weight로 대체시킴으로 catastrophic forgetting 방지 → 기존 (TENT)엔 BN의 weight만 학습했으므로, 학습 가능한 capacity 가 증가함

-

-

-

Continual Test-Time Domain Adaptation

- online continual test-time adaptation

- related works

- domain adaptation

- test-time adaptation

- domain generalization

- continual learning

- related works

- online continual test-time adaptation

-

Methodology

-

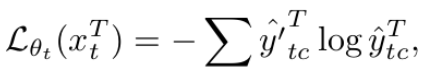

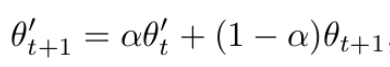

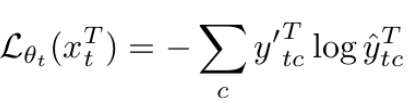

Weighted Averaged Pseudo Labels

-

EMA teacher 의 soft-label을 pseudo label로 사용함

-

-

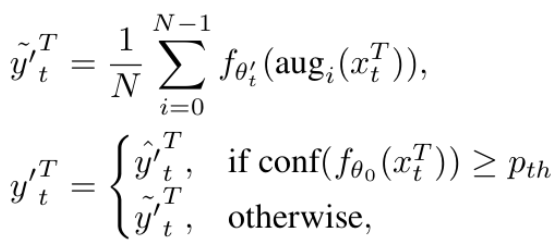

Augmentation-Averaged Pseudo-Labels

-

가정 : Source-trained Fixed Teacher weight가 있음

-

가정 2: Target domain과 source domain간의 gap이 클수록, confidence score가 낮아짐

-

Domain Gap이 클 경우엔 서로 다른 N개의 augmentation을 수행하여 평균 vector를 pseudo label로 활용함

- $p_th$ : confidence threshold

- $conf(f_{\theta_0})$ : source-fixed model의 confidence score

-

-

-

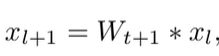

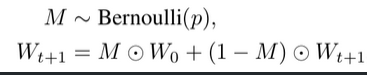

Stochastic Restoration

-

장기간 adaptation할 경우, source의 정보를 catastrophic forgetting할 수 있음

-

모델의 weight를 random하게 source의 weight로 대치시킴 → Drop-out효과 (Regulaization)

-

-

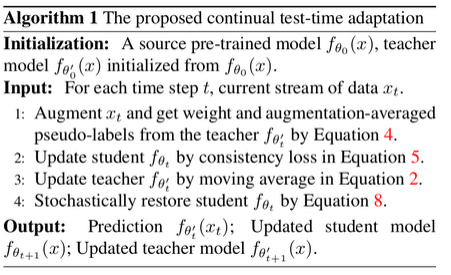

Overall Algorithm

-

Overall Sturcture